Comprendre l’IA Act européen – Une analyse approfondie pour tous les professionnels

Introduction

L’Union européenne a franchi une étape historique avec l’adoption du Règlement (UE) 2024/1689 du 13 juin 2024 – communément appelé IA Act – publié au Journal officiel de l’Union européenne le 12 juillet 2024. Ce texte dote l’Europe du premier cadre législatif horizontal entièrement consacré à l’intelligence artificielle (IA). Il s’inscrit dans une stratégie plus large de régulation du numérique aux côtés du RGPD, du Digital Services Act (DSA) et du Digital Markets Act (DMA).

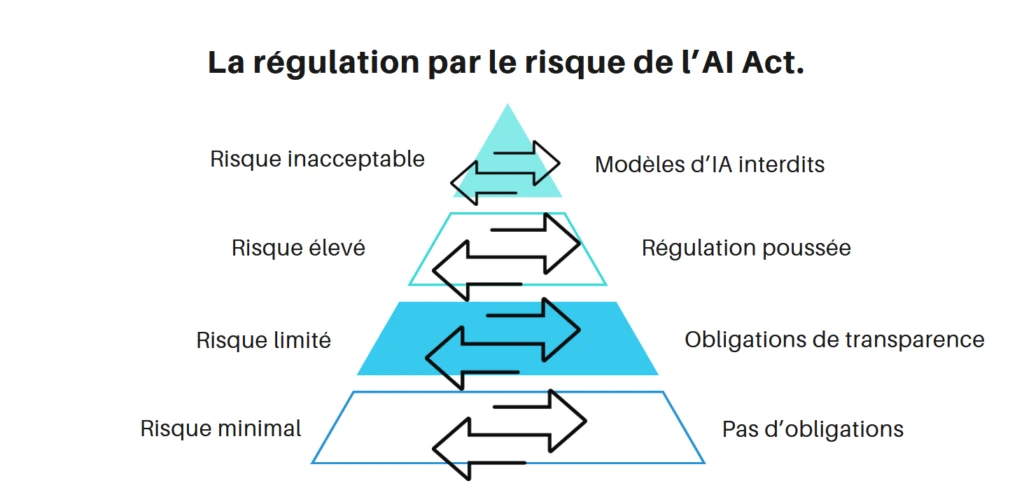

Ce règlement dote l’UE d’une réglementation souple et modulable, fondée sur le principe de proportionnalité du risque. Cette approche permet d’encadrer l’usage de l’IA tout en favorisant l’innovation et la compétitivité technologique.

Ce billet propose une analyse approfondie du contenu, des objectifs, des dispositifs, des enjeux et des perspectives du texte, en s’appuyant notamment sur les travaux de référence du cabinet Gide dans son livret de décembre 2024.

1. Genèse et philosophie de l’IA Act

Le développement rapide de l’IA, en particulier de l’IA générative, a fait naître de nouveaux enjeux de souveraineté technologique, de protection des droits fondamentaux, de cybersécurité, mais aussi de distorsions de concurrence. La Commission européenne a publié une première proposition en avril 2021. Après trois ans de discussions, un accord politique a été trouvé en décembre 2023, avant validation finale en mai 2024.

L’IA Act repose sur quatre piliers :

- Une approche graduée fondée sur le risque,

- Une responsabilité accrue des fournisseurs et déployeurs,

- Un contrôle administratif européen et national renforcé,

- L’émergence d’un modèle européen de gouvernance de l’IA, à visée mondiale.

2. Échéances et mise en conformité : un agenda à anticiper

Le Règlement sur l’IA a été publié au Journal officiel de l’Union européenne le 12 juillet 2024. Conformément à son article 113, il est entré en vigueur le 1er août 2024, mais la plupart de ses dispositions seront applicables à compter du 2 août 2026, à l’issue d’une période de 24 mois. Cette structuration temporelle vise à laisser aux acteurs économiques le temps de se préparer, tout en enclenchant dès à présent une dynamique d’alignement.

Des exceptions existent : les dispositions concernant les systèmes d’IA interdits et les modèles à usage général à risque systémique entrent en application dès février 2025. Les exigences spécifiques relatives aux systèmes à haut risque déjà régulés par d’autres textes sectoriels peuvent quant à elles attendre 36 mois (jusqu’en août 2027).

Au-delà des échéances formelles, le texte appelle une anticipation active. Il ne s’agit pas simplement d’attendre l’entrée en vigueur, mais de cartographier dès aujourd’hui les systèmes d’IA utilisés ou déployés, de mettre à jour les contrats fournisseurs, d’organiser la documentation technique, et de désigner un référent IA au sein des structures concernées.

Pour les professionnels du droit, ces délais sont l’opportunité de positionner leur expertise : accompagnement des audits internes, conformité des projets IA, élaboration de chartes éthiques, ou encore formation des équipes. Plus qu’une course contre la montre, il s’agit de construire une culture juridique de la conformité algorithmique, afin d’éviter les risques de rupture brutale, de contentieux ou de perte de compétitivité.

- Entrée en vigueur : 1er août 2024

- Application générale : 2 août 2026

- Dispositions anticipées :

- Février 2025 : interdictions (art. 5)

- Août 2025 : GPAI

Des lignes directrices sont attendues dès 2025 (art. 96).

3. Champ d’application matériel et territorial

3.1 Portée matérielle

Le règlement s’applique aux systèmes d’IA définis à l’article 3(1) comme « des systèmes automatisés qui, pour des objectifs explicites ou implicites, déduisent à partir des données reçues des prédictions, du contenu, des recommandations ou des décisions pouvant influer sur des environnements physiques ou virtuels ».

Cette définition, alignée sur celle de l’OCDE, permet d’inclure les IA à usage général tout en excluant les logiciels classiques.

3.2 Portée territoriale

L’article 2(1) consacre une portée extraterritoriale, comme le RGPD. L’IA Act s’applique dès lors qu’un système d’IA est :

- Mis sur le marché ou utilisé dans l’UE,

- Ou que ses résultats sont exploités par des utilisateurs situés dans l’UE.

4. Classification des systèmes d’IA selon le risque

4.1 Risque inacceptable (Article 5, IA Act)

Ces systèmes sont strictement interdits car ils sont jugés incompatibles avec les valeurs fondamentales de l’Union européenne.

- Techniques manipulatives ou subliminales altérant le comportement (5.1 a),

- Exploitation des vulnérabilités d’enfants ou de personnes handicapées (5.1 b),

- Notation sociale (5.1 c),

- Utilisation de la reconnaissance biométrique en temps réel à des fins policières sauf exceptions (5.1 h).

4.2 IA à haut risque (Articles 6 à 29)

Ces systèmes ne sont pas interdits mais sont fortement encadrés, car ils peuvent avoir des effets significatifs sur la vie des personnes. Ils doivent répondre à des exigences strictes de sécurité, traçabilité, transparence, et supervision humaine.

Ce sont les systèmes ayant un impact significatif sur les droits fondamentaux. Ils incluent :

- L’éducation (notation automatisée),

- L’emploi (tri de CV),

- L’accès à des services publics ou essentiels (santé, crédit),

- La justice, les procédures administratives, etc.

Les obligations comprennent :

- Une documentation technique,

- Une gouvernance des données (art. 10),

- Un système de gestion des risques (art. 9),

- Une transparence accrue (art. 13),

- Une supervision humaine (art. 14).

4.3 Risque limité (Article 50)

Ces systèmes interagissent avec le public, mais sans impact direct sur les droits fondamentaux. Ils doivent seulement respecter des obligations de transparence. Ces systèmes (chatbots, deepfakes) doivent informer clairement les utilisateurs qu’ils interagissent avec une IA. L’objectif est d’éviter toute confusion ou manipulation.

Exemples :

- Chatbots,

- Deepfakes (contenus générés ou modifiés par IA),

- IA imitant une personne réelle ou une situation réelle (voix, image, etc.).

Obligations :

- Informer clairement les utilisateurs qu’ils interagissent avec une IA,

- Étiquetage obligatoire des contenus synthétiques.

4.4 Risque minimal

Ce sont les systèmes à usage courant, souvent déjà régulés par d’autres textes, et qui ne posent pas de risques particuliers. Ils ne sont pas visés par des obligations spécifiques dans le cadre de l’IA Act, mais restent soumis à d’autres cadres légaux (ex. RGPD, sécurité des produits).

Exemples :

- Filtres anti-spam,

- Recommandations de vidéos sur une plateforme,

- Jeux vidéo avec IA.

Les systèmes comme les filtres anti-spam ne sont pas soumis à des exigences particulières, mais doivent respecter la législation générale.

5. Dispositif de mise en conformité

L’entrée en application du Règlement IA en août 2026 impose aux organisations concernées – entreprises, administrations, professions réglementées – de se doter dès à présent d’une démarche de mise en conformité rigoureuse et anticipée. Loin de se réduire à un exercice technique, cette conformité engage la responsabilité juridique, la réputation et parfois même la licéité des activités fondées sur des systèmes d’IA.

Le texte repose sur une logique de co-régulation : il fixe des obligations précises, tout en encourageant l’autorégulation (codes de conduite, bonnes pratiques, chartes internes). Dans ce cadre, les opérateurs sont invités à construire une gouvernance interne de l’IA, documentée et traçable, en proportion du niveau de risque de leurs systèmes.

La mise en conformité implique donc un travail de fond : identifier les cas d’usage concernés, qualifier les niveaux de risque, adapter les processus internes, contractualiser les obligations entre acteurs de la chaîne de valeur. Cette démarche suppose aussi une implication transversale des directions juridiques, informatiques, métiers, conformité et gouvernance.

5.1 Auto-évaluation et marquage CE

Les fournisseurs doivent :

- Réaliser une évaluation de conformité (art. 43),

- Rédiger une déclaration UE de conformité (art. 47),

- Obtenir le marquage CE (art. 48).

Un registre public des systèmes à haut risque est créé (art. 49).

5.2 Évaluation des risques systémiques pour les GPAI

Les modèles à usage général entraînés avec une puissance supérieure à 10^25 FLOPs sont soumis à :

- Une analyse d’impact,

- Des audits de sécurité et de robustesse,

- Une transparence sur l’entraînement et les données utilisées (art. 53).

6. Sanctions (Article 99)

L’un des aspects les plus notables de l’IA Act réside dans son régime de sanctions, pensé pour être à la fois dissuasif, proportionné et adapté à la diversité des acteurs concernés. En effet, le législateur européen a clairement choisi de s’inspirer du modèle instauré par le RGPD, en instaurant une architecture graduée de sanctions administratives, fondée sur la gravité des manquements.

Trois plafonds d’amendes sont prévus :

- Jusqu’à 35 millions d’euros ou 7 % du chiffre d’affaires mondial pour l’utilisation de systèmes d’IA interdits ;

- Jusqu’à 15 millions d’euros ou 3 % pour les autres violations (manquements aux obligations sur les systèmes à haut risque, défauts de transparence…) ;

- Et 7,5 millions d’euros ou 1 % pour les cas de communications inexactes ou incomplètes aux autorités.

Ce régime s’applique également aux acteurs hors UE dès lors que leurs systèmes sont mis sur le marché européen ou que leurs résultats sont utilisés dans l’UE (principe d’extraterritorialité). Les PME et start-ups bénéficient cependant d’un plafond réduit, signe d’un effort de proportionnalité.

Pour les professionnels du droit, cette sévérité crée un nouveau champ de vigilance : conformité des contrats fournisseurs, gestion des risques en M&A, évaluation des litiges potentiels liés à l’IA. Ce système de sanctions impose une mise en conformité proactive et crée un nouveau terrain d’intervention pour les avocats spécialisés en droit numérique, conformité réglementaire et contentieux technologique.

7. Les modèles à usage général et la réponse européenne

Les modèles d’IA à usage général (General Purpose AI – GPAI), tels que ChatGPT, Gemini ou Mistral, occupent une place cruciale dans l’écosystème numérique actuel. Leur polyvalence — traduction automatique, génération de texte, classification d’image, rédaction de code — en fait des instruments transversaux, intégrables dans des applications aux finalités multiples. L’IA Act prend acte de cette réalité en créant, pour la première fois au monde, un régime juridique spécifique applicable à ces modèles.

Ces GPAI sont soumis à deux niveaux d’obligations, selon leur impact potentiel. Tous doivent respecter des exigences de transparence : documentation technique, informations sur l’entraînement du modèle, respect du droit d’auteur, mise à disposition de guides pour les intégrateurs. Mais lorsqu’un modèle est jugé susceptible de générer un risque systémique — ce qui est présumé au-delà de 10²⁵ opérations de calcul — un régime renforcé s’applique : évaluation des risques, tests contradictoires, cybersécurité, reporting régulier.

L’UE se positionne ainsi comme un pionnier normatif face à des géants majoritairement américains. Elle impose aux fournisseurs de GPAI d’anticiper les usages potentiels et de garantir leur maîtrise technologique, quel que soit l’usage aval. Ce choix reflète une philosophie de précaution encadrée, visant à maintenir l’innovation tout en responsabilisant les opérateurs d’infrastructures critiques.

Pour les juristes, cela signifie l’émergence d’un nouveau périmètre de conseil : due diligence algorithmique, audit de modèles préexistants, encadrement des usages dérivés, avec des implications contractuelles, réglementaires et contentieuses majeures.

8. Le rôle des autorités nationales et européennes : une gouvernance en réseau

L’application du Règlement sur l’IA repose sur une architecture institutionnelle articulée entre autorités nationales, organes européens et acteurs techniques. Ce réseau vise à garantir à la fois l’uniformité de la mise en œuvre et l’adaptabilité aux réalités nationales.

Chaque État membre doit désigner une ou plusieurs autorités compétentes pour surveiller la conformité des systèmes d’IA relevant de leur périmètre sectoriel (santé, finances, éducation, sécurité…). En France, cela pourrait mobiliser des institutions telles que la CNIL, l’ANSSI, l’ARCOM, ou les autorités administratives indépendantes selon les domaines. Ces autorités pourront enquêter, ordonner des retraits du marché, et infliger des amendes.

Au niveau européen, un Comité européen de l’IA (analogue au CEPD pour le RGPD) assurera la coordination des politiques, le partage des bonnes pratiques et l’interprétation uniforme du droit. Ce comité s’appuiera sur un forum consultatif composé d’acteurs industriels, d’ONG, de chercheurs et de praticiens. Pour les GPAI, un Bureau européen de l’IA, hébergé par la Commission européenne, aura un rôle central de supervision, notamment pour les risques systémiques.

Cette gouvernance distribuée répond à un double impératif : proximité avec les réalités sectorielles et cohérence d’ensemble au sein du marché intérieur. Elle implique, pour les professionnels du droit, de maîtriser les relations interinstitutionnelles et de suivre de près les positions prises par ces autorités, notamment en matière de lignes directrices, de codes de conduite et de contentieux transnationaux.

8.1 Supervision au niveau européen

Au niveau européen, la supervision sera orchestrée essentiellement via :

- Comité européen de l’IA (art. 65),

- Bureau européen de l’IA, créé le 29 mai 2024, dans un rôle de supervision des GPAI; et qui émet des recommandations techniques, et coordonne les autorités nationales.

8.2 Supervision au niveau national (France)

Le choix de l’autorité centrale reste en discussion. Il est probable que la CNIL soit compétente pour les aspects relatifs aux données personnelles, et l’ANSSI pour la cybersécurité. Les autorités sectorielles (ACPR, ARCOM, etc.) seront également mobilisées.

9. Enjeux pratiques pour les professionnels du droit

9.1 Pour les avocats, juristes d’entreprise et départements compliance

Les professionnels du droit devront adapter leurs pratiques aux nouvelles exigences de l’IA Act. Cela implique :

- Mettre en place des audits internes : identifier les systèmes d’IA déployés par l’entreprise ou utilisés dans les services juridiques.

- Contrôler la conformité contractuelle : vérifier que les contrats avec les fournisseurs de solutions IA incluent des clauses relatives à la transparence, à la documentation et à la gestion des risques.

- Veiller au respect du RGPD parallèlement à l’IA Act : notamment en matière de base légale du traitement, de minimisation des données et de droits des personnes concernées.

- Former les équipes juridiques : sur les notions clés du règlement (typologie de risque, obligations de documentation, audit, etc.).

- Préparer la gestion de crise : mettre en place des procédures internes pour signaler les incidents graves causés par un système d’IA.

9.2 Pour les magistrats, arbitres, et professions juridiques réglementées

- Intégrer les nouvelles notions de responsabilité : évaluer les effets juridiques de décisions assistées ou prises par l’IA.

- Apprécier la preuve algorithmique : se prononcer sur la licéité, la pertinence et la compréhensibilité de la preuve fournie par ou contre un système d’IA.

- Encadrer l’utilisation judiciaire de l’IA : exiger une explicabilité minimale des outils d’aide à la décision, notamment dans les litiges en matière sociale, commerciale ou pénale.

Conclusion

L’IA Act est un texte fondateur. Il place l’Union européenne à l’avant-garde d’une régulation ambitieuse, conciliant innovation et protection des droits. Pour les professionnels du droit, il constitue un champ d’analyse, d’action et d’opportunités. L’enjeu est double : accompagner les entreprises vers la conformité tout en préservant l’état de droit à l’ère algorithmique.

La France, forte d’une doctrine active (CNIL, Conseil d’État) et d’une expertise technique (ANSSI, INRIA), a une carte à jouer dans l’interprétation et la mise en œuvre de cette nouvelle architecture juridique.

Professionnels du droit, ce règlement est une invitation à agir : pour encadrer l’IA, il faut d’abord la comprendre en profondeur.